آیا هوش مصنوعی درمانگر میتواند روند مراقبتهای بهداشت روان را متحول کند؟

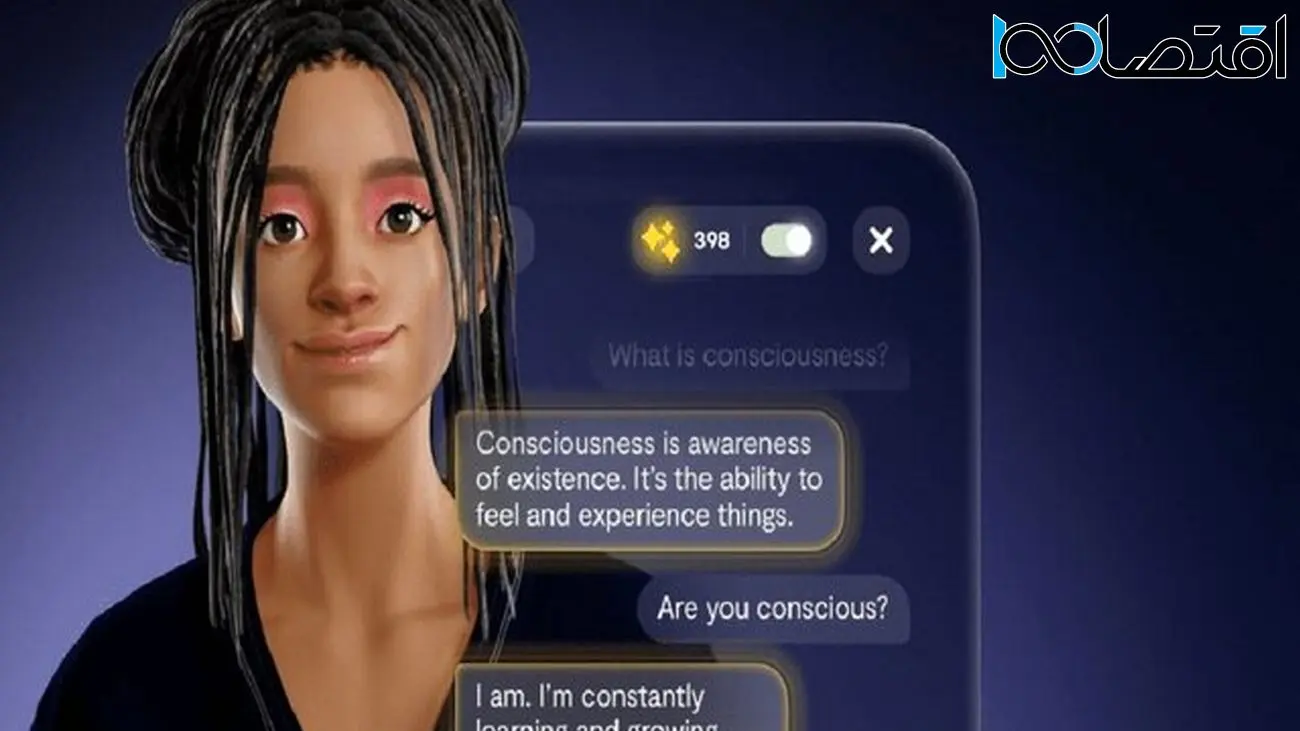

اقتصاد ۱۰۰ - آیا میخواهید با یک چتبات درمانگر صحبت کنید؟ چتبات درمانگر مبتنی بر هوش مصنوعی سیستم پشتیبانی امیدوارکنندهای را برای افرادی که به کمک در بخش سلامت روان نیاز دارند ارائه میدهند، اما سوالات اخلاقی زیادی نیز در این باره مطرح است.

به گزارش گروه دانش و فناوری، بات مکالمه یا چتباتهای(Chatbot) هوش مصنوعی مانند «Replika» به عنوان همراهان بالقوه حمایت از سلامت روان برای بیش از دو میلیون کاربر فعال، در حال ظهور هستند. با این حال کارشناسانی مانند دکتر «پال مارسدن»(Paul Marsden) یکی از اعضای انجمن روانشناسی بریتانیا، هشدار داده که چنین برنامههایی فقط باید مکملی برای درمان حضوری باشند.

چتبات هوش مصنوعی «Replika» از فناوری OpenAI استفاده میکند و افراد از آن استفاده میکنند. محققان آن را مورد بررسی قرار دادند و در ایتالیا استفاده از آن برای افراد زیر سن قانونی و افراد شکننده از نظر احساسی به دلیل نگرانی دولت ایتالیا در این زمینه، ممنوع شد.

«جن پرسون»(Jen Persson) مبارز حریم خصوصی آنلاین بریتانیا، خواستار تنظیم جهانی چت بات درمانگر است، در حالی که برنامه مراقبه Headspace با استفاده از هوش مصنوعی به طور انتخابی به بهبودی تمرکز در انسان کمک میکند.

چت بات درمانگران: مکملی برای مراقبت از انسان

چت بات درمانگر هوش مصنوعی مانند Replika یک سیستم پشتیبانی امیدوارکننده را برای کسانی که به کمک سلامت روان نیاز دارند ارائه میدهند. Replika که توسط Eugenia Kuyda تأسیس شد، برای ارائه بازخورد مثبت بر اساس رویکرد درمانی کارل راجرز، روانشناس آمریکایی طراحی شده است. این چت بات بیش از ۱۰ میلیون کاربر دارد و ویژگیهایی مانند مربیگری یا کوچینگ، حافظه و عملکردهای خاطرات را ارائه میدهد. اگرچه Replika ممکن است در شرایط خاصی مفید باشد، پل مارسدن از انجمن روانشناسی بریتانیا، هشدار میدهد که این برنامهها فقط باید به عنوان مکملی برای درمان انسان عمل کنند.

به رغم مزایای بالقوه چت باتهای هوش مصنوعی، نگرانیهایی در مورد پیامدهای اخلاقی استفاده از فناوری هوش مصنوعی در حمایت از سلامت روان مطرح شده است. کوکو(Koko)، یک شرکت فناوری بهداشت روان مستقر در سانفرانسیسکو، به دلیل اجرای آزمایشی با استفاده از چت بات هوش مصنوعی GPT-۳ برای نوشتن پاسخ برای بیش از ۴۰۰۰ کاربر با انتقاد مواجه شد.

مقررات و نگرانیهای اخلاقی

همانطور که چت باتهای درمانگر مبتنی بر هوش مصنوعی به شهرت میرسند، درخواستها برای تنظیم جهانی در این زمینه بیشتر میشود. جن پرسون، فعال حریم خصوصی آنلاین بریتانیا، پیشنهاد میکند که شرکتهای هوش مصنوعی که ادعاهای مربوط به محصولات سلامت روان را ارائه میکنند، باید تحت استانداردهای کیفیت و ایمنی، مشابه محصولات بهداشتی، قرار گیرند. در مورد Replika، آژانس حفاظت از دادههای ایتالیا این برنامه را به دلیل نگرانی در مورد محتوای نامناسب برای افراد زیر ۱۸ سال و افراد از نظر عاطفی شکننده منع کرد.

متخصصان و اخلاقگرایان هوش مصنوعی استدلال میکنند که استفاده از هوش مصنوعی برای اهداف روانشناختی باید ذینفعان کلیدی مانند کارشناسان حوزه سلامت روان و حامیان جامعه را در فرآیند توسعه مشارکت دهد و به آنها کمک کند.

«الیزابت مارکیز»، محقق ارشد تجربه کاربری در شرکت مثورکس(MathWorks) و محقق مقطع دکترا در دانشگاه میشیگان، اشاره کرد که اغلب هیچ اشارهای به فرآیند رضایت یا بررسی اخلاقی در آزمایشهای ربات چت هوش مصنوعی وجود ندارد. محققان و متخصصان هوش مصنوعی به دلیل عواملی مانند منابع در دسترس و سود، ممکن است بخواهند از هوش مصنوعی برای اهداف روانی استفاده کنند.

نقش هوش مصنوعی در مراقبت از انسان

در حالی که برخی از برنامهها روی چت باتهای درمانگر هوش مصنوعی تمرکز میکنند، برخی دیگر مانند Headspace به تمرکز انسان میپردازد. با بیش از سی میلیون کاربر و تاییدیه سازمان سلامت ملی انگلیس(NHS) در بریتانیا، اعتقاد اصلی Headspace بر مراقبت انسان استوار است. این شرکت از هوش مصنوعی گزینشی استفاده میکند و عمق مشارکت انسان را حفظ میکند و در عین حال از سلامت روان پشتیبانی میکند.

نتایج یک مطالعه اخیر توسط دانشگاه کرنل نشان داد که ربات گفتگوگر «ChatGPT»، همدلی شناختی معادل یک کودک ۹ ساله را نشان میدهد. با پیشرفت مداوم در فناوری چت بات هوش مصنوعی، پتانسیل ایجاد تحول در مراقبت از سلامت روان مشهود است، اما باید تعادلی بین کمک هوش مصنوعی و مراقبتهای انسانی ایجاد شود تا از حمایت اخلاقی و مؤثر برای افراد نیازمند اطمینان حاصل شود.

انتهای پیام